한국과학기술원(KAIST) 연구진이 기존 인공지능(AI) 기술을 뛰어넘는 양자 AI 알고리즘 개발에 성공했다. 복잡한 데이터를 적은 계산량으로 처리할 수 있게 됐다.

KAIST는 이준구 전기및전자공학과 및 AI 양자컴퓨팅 IT 인력양성연구센터 교수 연구팀이 독일·남아공 연구팀과의 협력 연구로 ‘비선형 양자 기계학습 AI 알고리즘’을 개발했다고 7일 밝혔다.

이번 연구로 복잡한 데이터에 대한 양자 기계학습이 가능하게 됐다. 이 교수팀이 개발한 양자 지도학습 알고리즘은 학습에 필요한 적은 계산량만으로 연산이 가능하다. 대규모 계산량을 필요로 하는 현재 AI 기술을 추월할 가능성을 제시한 것으로 평가받는다.

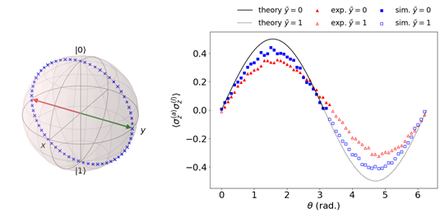

연구팀은 양자컴퓨팅의 장점을 기반으로 기하급수적인 계산 효율성을 달성하는 양자 기계학습 알고리즘을 개발했다. 양자컴퓨팅은 ‘큐비트(양자컴퓨팅 정보처리의 기본 단위)’의 개수에 비례해 정보 공간의 차원이 증가하기 때문에 이론적으로 고차원 정보처리에 있어 뛰어난 성능을 낸다는 점을 활용했다.

더불어 양자 회로를 체계적으로 설계해 다양한 양자 커널 구현이 가능함을 이론적으로 증명했다. 커널 기반 기계학습에서는 주어진 입력 데이터에 따라 최적 커널이 달라질 수 있으므로 여러 양자 커널을 효율적으로 구현할 수 있게 됐다는 점에서 높이 평가된다.

이번 연구에 참여한 박경덕 연구교수는 "연구팀이 개발한 커널 기반 양자 기계학습 알고리즘은 복잡한 비선형 데이터의 패턴 인식 등에 활발히 사용될 것"이라며 "수백 큐비트를 99.9%의 정확도로 제어하는 NISQ 컴퓨팅 시대가 도래하면 기존의 고전 커널 기반 지도학습을 뛰어넘을 것으로 보인다ˮ고 말했다.

연구결과는 국제 학술지 네이처 자매지인 `Npj Quantum Information' 5월자 6권에 게재됐다. 이번 연구는 한국연구재단의 창의 도전 연구기반 지원 사업과 한국연구재단의 한-아프리카 협력기반 조성 사업, 정보통신기획평가원의 정보통신기술인력 양성사업(ITRC)의 지원을 받아 수행됐다.

장미 기자 meme@chosunbiz.com