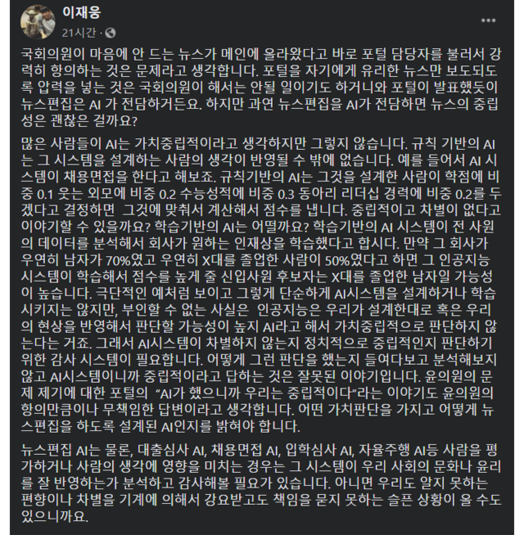

이재웅 전 쏘카 대표는 9일 자신의 SNS를 통해 윤영찬 더불어민주당 의원의 포털 압박 메시지에 대해 윤 의원과 포털 다음(daum)을 운영하는 카카오 모두에 대해 부정적인 의견을 내비쳤다.

다음을 창업한 이재웅 전 대표는 윤영찬 의원이 포털 다음(daum)의 뉴스 편집에 관한 지적도 문제지만, "뉴스 편집은 AI가 한다"는 카카오의 답변도 정당화될 수 없다고 지적했다. 이어 그는 "규칙 기반의 AI는 시스템 설계 하는 사람의 생각이 반영될 수밖에 없다"라고 설명했다.

단순한 양비론이 아니다. AI 설계 자체와 연관이 깊다.

현재 대부분 AI는 머신러닝(기계학습)을 기반으로 한다. 머신러닝은 대량의 데이터를 통해 학습하여, 적절한 규칙을 찾는 알고리즘이다. 좋은 AI를 위해서 많은 학습 데이터가 필요한 이유다.

하지만 AI는 학습 데이터만 필요하지 않다. 좋은 규칙을 찾기 위해서는 일종의 "해답"에 해당하는 데이터가 필요하다. AI 알고리즘은 여러 학습 데이터를 해답과 비교하며 조건을 찾아간다.

예를 들어, 사과를 인식하는 AI는 해답에 해당하는 '사과 이미지'를 중심으로 학습 데이터에서 사과인지 아닌지 판단한다. 이를 통해 사과를 판단하는 조건을 배운다.

개발자의 입김은 바로 이 해답에 들어간다. 개발자가 정한 해답에 따라 AI는 학습하고 자신만의 조건을 만들어나간다. 설계상 AI는 가치중립적일 수 없는 것이다.

이재웅 전 대표는 "AI는 우리(개발자)가 설계한 대로 혹은 현상을 반영해서 판단할 가능성이 높다"라고 지적한 배경이다.

이미 사회 편견을 학습한 AI가 차별적으로 판단한 사례는 전 세계에서 나오고 있다. 인종차별이 대표적이다. 범죄 관련 AI를 개발하던 미국은 학습 데이터가 흑인으로 편중돼, 흑인 거주지를 우범지대로 낙인찍었다.

성차별도 있었다. 아마존이 개발한 AI 채용프로그램은 '여성'키워드가 있으면, 채용 자체를 하지 않는 경우가 보고됐다. IT 직무에 채용된 여성 직원이 근속연수가 짧다는 이유로 AI가 기회도 주지 않은 것이다.

AI 가치중립성 문제는 여기서 끝나지 않는다. 머신러닝 기반의 대다수 AI가 학습한 '조건'을 알 수 없다. 앞서 설명한 사과 인식 AI 경우, AI가 사과라고 판단한 근거를 알 길이 없다는 것이다.

이번 포털 문제로 대입하면, 특정 뉴스가 자주 나오는 근거를 추정할 수 있어도 정확한 이유를 파악하기 힘들다. 이를 방지하기 위해서는 AI 활용 기업의 지속적인 관리가 필수다. 이재웅 전 대표도 "(AI가) 중립적인지 판단하기 위한 감사 시스템이 필요하다"라고 밝혔다.

다음은 설립 25년이 넘은 장수 포털이다. 하지만 카카오는 윤영찬 의원의 지적에 "뉴스 편집은 AI가 한다. 사람이 (특정 기사를) 넣고 빼는 것이 아니다"라고 답했다.

카카오의 정확한 의도는 알 수 없다. 하지만 그들의 대답은 AI에 대해 무지하거나, 그보다 AI에 관한 대중의 무지에 기댄 발언일 가능성이 높다. 이 전 대표의 표현처럼 "무책임한 답변"이다.