"엣지컴퓨팅 시대가 도래하면서 인공지능(AI) 추론을 위한 컴퓨팅 파워의 중요성이 날로 커지고 있습니다. 대표적인 예가 바로 AI 스피커입니다."

XDF 2018에서 ‘누구'가 등장한 이유는 SK텔레콤이 자동 음성인식 성능을 높이기 위해 자일링스와 협업해 프로그래머블 반도체(FPGA) 기반 AI 가속기를 개발해 자사 클라우드 데이터센터에 적용했기 때문이다. 국내 대규모 데이터센터에 FPGA 기반 상용 AI 가속기를 채택한 사례는 이번이 처음이다. 글로벌 시장에서는 이미 아마존, 마이크로소프트, 알리바바, 바이두 등이 클라우드 데이터센터에 FPGA를 도입한 바 있다.

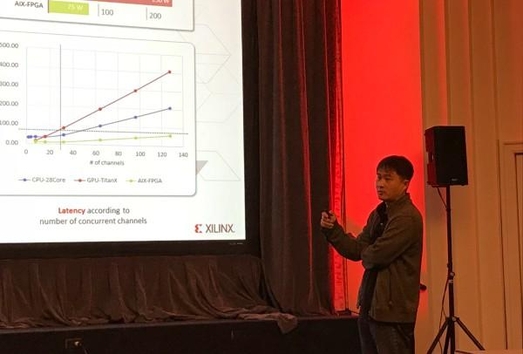

자일링스는 SK텔레콤과의 협업을 높게 평가하며 이번 XDF 2018에서 별도 세션을 통해 ‘누구' 사례를 전 세계 개발자와 공유하는 자리를 마련했다. 세션에서는 안민욱 SK텔레콤 머신러닝 인프라 랩 모듈 선임개발자가 참석해 자일링스와 함께 FPGA 기반 AI 가속기를 만들게 된 배경과 성과, 앞으로의 계획 등을 발표해 큰 주목을 받았다.

실제 ‘누구' 이용자 수는 2017년 8월만 해도 월간 실사용자 수(MAU) 기준 11만명, 대화 처리량 1억건에 불과했다. 하지만, 같은 해 8월 ‘누구 미니'를 출시하고, 9월에는 내비게이션 서비스 T맵에 ‘누구'를 결합하면서 사용자 수가 단숨에 급증했다. 2018년 들어 SK브로드밴드 BTV에도 ‘누구'가 탑재되면서 MAU 300만명을 돌파했고, 대화 처리량은 11억건을 넘어섰다.

SK텔레콤은 데이터센터 내 서버의 CPU와 메모리를 증설하는 단순한 스케일 업 방식의 대응으로는 고객 수요를 감당하기 힘들다고 판단했다. 또 GPU의 경우 병렬 연산으로 머신러닝에 최적화된 것으로 알려졌지만, 비용과 전력 효율을 고려하면 대량으로 도입하기 부담스러운 형편이었다.

SK텔레콤이 2년간 자일링스와 협업해 개발한 AI 가속기는 자일링스의 킨텍스 울트라스케일 KU115를 기반으로 75W 전력으로 초당 3조회(3TOPs) 명령어를 처리하는 성능을 구현했다. 28코어 CPU의 경우 100W, 엔비디아 타이탄X GPU의 경우 250W의 전력을 소모하는 것과 비교하면 단연 효율성이 높다.

나아가 채널 수 증가에 따른 처리량과 지연시간(레이턴시)를 고려하면, 성능만 놓고 봤을 때 AI 가속기가 GPU보다 5배, 와트당 성능으로 환산했을 때는 16배나 높은 성능을 보였다는 게 SK텔레콤의 결론이다.

SK텔레콤은 자일링스 FPGA를 기반으로 AI 가속기의 성능을 지속적으로 향상시키고, 음성인식뿐 아니라 비디오, 자연어처리, 음성결합 등으로 적용 분야를 넓혀 나간다는 계획이다.

안민욱 선임개발자는 "자일링스의 더 진화한 FPGA 솔루션인 버텍스 VU9P를 기반으로 한 하이엔드 AI 가속기를 내년 1분기쯤 개발 완료해 선보일 예정이다"라며 "전력 소모량은 늘어나겠지만, 컴퓨팅 용량을 33TOPs로 기존 대비 10배 이상 늘려 다계층신경망(MLP)뿐 아니라 순환신경망(RNN), 회선신경망(CNN) 등 신경망 네트워크를 확장해 나갈 것이다"라고 말했다.