애플이 ‘애플 글래스(Apple Glass, 가칭)’로 알려진 자사의 증강현실(AR) 디바이스와 관련된 새로운 특허를 출원했다.

새롭게 출원한 이번 특허는 기존에 만들어진 180도 또는 360도 영상이나 이미지를 애플의 AR 디바이스로 불러오면 이를 더욱 입체적이고 사실적으로 보이면서 상호작용까지 가능한 가상 영상으로 바꾸어 보여주는 내용을 담고 있다.

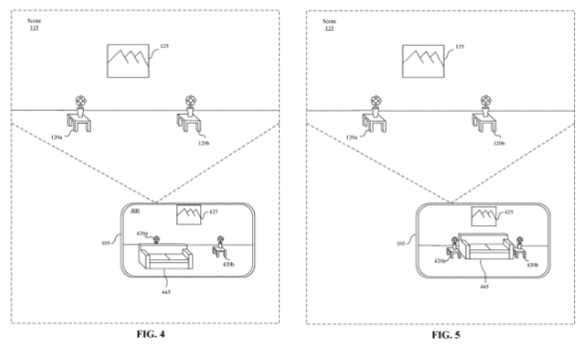

또한, 180도~360도 영상이나 이미지가 단순히 각 방향 별로 촬영한 평면 이미지를 이어붙인 것인 만큼 3D로 오브젝트를 표현하는 AR 안경이나 HMD등으로 보면 시야각에 따라 화면 일부가 왜곡되어보일 수 있다.

애플의 새로운 특허는 이러한 문제점을 해결할 수 있는 내용을 담고 있다. 미리 만들어진 180도~360도 영상을 AR 안경이나 HMD로 불러와 재생하면, 기기에 내장된 영상 처리 시스템이 해당 영상을 분석하고, 영상 속 주요 사물이나 지형 등을 실시간 3D 렌더링 오프젝트로 입체화해 보여주는 것이 골자다.

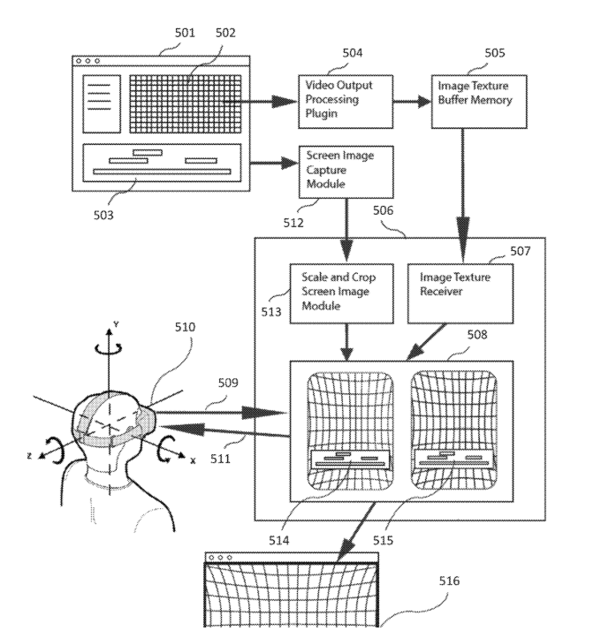

특허 내용에 따르면 이 기술은 AR 글래스나 VR HMD에서 180도~360도 영상을 불러와 재생할 때, 해당 화면을 디스플레이로 표시하는 GPU의 버퍼 데이터를 이용한다. 기기에 내장된 3D 이미지 처리 루틴이 현재 표시되는 장면의 버퍼 데이터를 3차원으로 해석하고, 각종 센서를 통해 수집한 주변 정보를 더해 영상 속에 보이는 사물이나 지형지물 등에 대해 위치와 방향, 거리 등의 3차원 정보를 생성한다.

이렇게 생성한 3차원 정보를 바탕으로, 주변 사물이나 지형 등을 실시간 3D 그래픽으로 렌더링해 사용자와 상호 작용이 가능한 AR 오브젝트로 표시한다. 실시간으로 생성된 3D AR 오브젝트는 AR 기기 사용자가 이동하거나 시점을 바꾸면 그에 맞춰 위치와 방향, 보이는 모습이 바뀌게 된다.

애플 글래스(가칭)에 이번 특허에서 설명하는 기술이 실제로 적용될수 있을지는 미지수다. 다만, 애플은 자사의 모바일 기기에 탑재된 다양한 카메라와 라이다(LIDAR) 등 각종 센서를 이용, 추가적인 장비가 없어도 주변을 3차원으로 인식하고 그에 맞춰 AR 오브젝트를 실시간으로 표시하는 수준의 기술력을 이미 갖춘 상태다.

최용석 기자 redpriest@chosunbiz.com

하순명 기자 kidsfocal@chosunbiz.com