AI GPU 기근설 목록

-

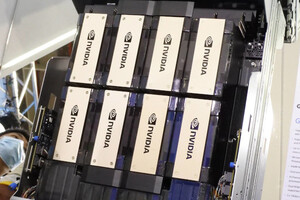

엔비디아 ‘H100’ 대안은… 다변화 지각변동에 기대감④ [AI GPU 기근설]

권용만 기자 2024.12.30 06:00 -

H100 GPU, 구하기도 어렵지만 쓰기는 더 어려워③ [AI GPU 기근설]

권용만 기자 2024.12.24 07:41 -

H100 GPU 공급난, 통계 인용 ‘무리수’ 가능성도② [AI GPU 기근설]

권용만 기자 2024.12.20 07:00 -

“국내 확보한 H100 GPU 2000개” 사실일까?① [AI GPU 기근설]

권용만 기자 2024.12.18 09:01