인공지능(AI)에 대한 높은 관심과 함께, 데이터센터용 인공지능(AI) 가속기 시장은 연간 70% 이상 성장할 것으로 예상되고 있다. 이러한 시장 기회를 앞두고, AMD는 데이터센터용 차세대 AI 가속기인 ‘MI300X’를 5월부터 본격적으로 고객사에 공급할 것이라고 밝혔다.

AMD는 20일 서울 강남구 코엑스 인터컨티넨탈 호텔에서 기자간담회를 열고, 데이터센터에서 엣지, AI PC에 이르는 광범위한 AI 시장 대응 전략을 소개했다.

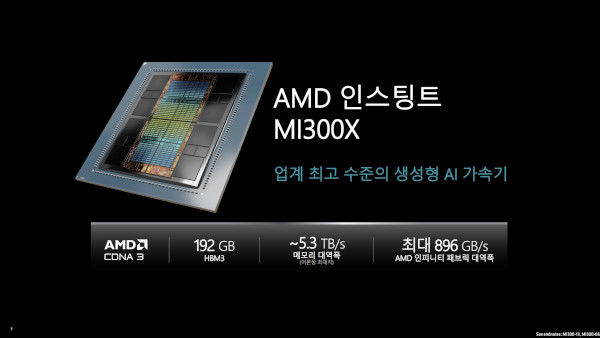

데이터센터의 AI와 HPC 워크로드에 최적화된 AMD의 MI300X AI 가속기는 지난 2023년 6월 처음 공개된 바 있으며, CDNA 3 아키텍처 기반의 XCD 8개와 192GB 용량의 HBM3 메모리를 갖추고 있다. 제품은 OAM 폼팩터를 활용하며, 제품 단위가 아닌 플랫폼 모듈 형태로 파트너사의 제품을 통해 제공될 예정이다.

혁신적 기술 'AI', 시장 규모 폭발적 확장 기대

이재형 AMD코리아 커머셜 세일즈 대표는 “AI는 최근 50년만에 등장한 가장 혁신적인 기술”이라고 평하며, 올해는 거대언어모델 뿐 아니라 좀 더 다양한 방향의 활용과 영향력이 등장할 것으로 기대했다.

또한 데이터센터용 AI 가속기 시장은 1년 전 예측했던 ‘연간 50% 성장으로 2027년 1500억달러(한화 약 201조원) 규모 시장으로 성장’을 뛰어넘어, ‘연간 70% 이상 성장해서 2027년 4000억달러(한화 약 536조원)까지 성장할 것으로 전망했다. 그리고 이런 성장 추이는 LLM 뿐만 아니라, 앞으로 펼쳐질 거대한 ‘추론’ 시장의 기대가 반영돼 있다고 덧붙였다.

AMD는 앞으로 펼쳐질 이러한 거대한 시장 기회에 대해, 기존의 데이터센터 위주 학습 시장 뿐 아니라 엔드포인트의 추론 영역까지 아우르는 AI 인프라의 모든 영역에 걸친 ‘엔드 투 엔드’ 솔루션을 공급할 수 있는 포트폴리오를 갖추고 있다고 강조했다. 또한 향후 5년 내에 모든 포트폴리오에 AI 기술을 접목한다는 목표에 대해서도, 이미 현재도 제품군 대부분에 AI 관련 기술이 접목되고 있다고 덧붙였다.

한편, AMD는 앞으로의 AI 시대에 대응하기 위해 광범위한 포트폴리오와 함께 ‘개방적이고 검증된 소프트웨어 역량’ 측면을 강조했다. 이 대표는 “모든 영역에서 AI가 적용되는 시대다. 엣지에서 클라우드까지 생태계 통합이 가능하려면 개방형 생태계로 움직여야 한다. AMD는 이에 대해, 개방형 소프트웨어 생태계에 적극적으로 투자하고 있다”고 밝혔다.

‘MI300X’ AI 가속기, 5월부터 고객사에 본격 공급 예정

이어 김홍필 AMD코리아 데이터센터 및 클라우드 솔루션 아키텍트 이사가 AMD의 데이터센터를 위한 주요 제품군을 소개했다. AMD의 ‘인스팅트(Instinct) MI300 시리즈’ 가속기는 AI와 고성능 컴퓨팅(HPC) 환경에서의 연산에 집중한 아키텍처를 기반으로 하며, ‘에픽(EPYC)’ CPU 또한 전통적인 데이터센터 뿐만 아니라 AI 데이터센터에서도 높은 경쟁력을 제공한다.

‘인스팅트 MI300X’는 전통적인 ‘연산 집약적’ 가속기로, CDNA3 아키텍처 기반의 XCD(Accelerated Compute Die) 8개와 HBM3 메모리 스택 8개, 입출력(I/O) 다이 4개 등을 2.5D 실리콘 인터포저와 3D 하이브리드 본딩 등으로 묶었다. 메모리 용량은 192GB, 대역폭은 5.3TB/s로, 경쟁 제품 대비 큰 메모리로 대규모 모델에서도 여유있는 환경을 제공한다.

AMD는 이 ‘MI300X’ 가속기를 기본적으로 ‘플랫폼’ 관점에서 다룬다는 계획을 제시했다. 플랫폼 관점에서, MI300X 가속기는 한 보드에 8개 가속기가 탑재된 모듈 형태로 구성될 수 있고, GPU간에는 896GB/s 전송 속도를 제공하는 ‘인피니티 패브릭(Infinity Fabric)’ 기술로 직접 연결된다. 또한 표준 OAM(OCP Accelerator Module) 폼팩터를 사용해, 한 서버 플랫폼에서 OAM 기반의 다른 가속기와 플랫폼 공유가 가능하다고도 덧붙였다.

한편, ‘MI300X’는 이제 고객사에 본격적인 공급을 앞두고 있으며, 델이나 HPE, 레노버, 슈퍼마이크로 등 다양한 파트너와 협력해 다양한 제품을 공급할 예정이라고 소개했다. 또한 AMD는 5월부터 MI300X 가속기가 고객사에 인도돼, 최종 고객에 전달될 수 있을 것이라 밝혔다.

‘MI300A’는 CDNA3 기반 AI 가속기와 ‘젠 4’ 기반 x86 CPU 코어가 하나의 제품으로 구성된 ‘APU’ 형태인 것이 특징이다. ‘CDNA 3’ 아키텍처 기반의 XCD 6개, ‘젠 4’ 아키텍처 기반 CCD 3개와 128GB HBM3를 갖추고, CPU와 GPU가 HBM3 메모리 공간을 공유해 사용할 수 있어 데이터 이동을 줄여 성능을 높일 수 있는 것이 특징이다.

AMD는 이 제품이 가속기와 CPU가 함께 처리하는 복합 워크로드 형태에 최적화됐으며, HPE나 에비덴(EVIDEN), 기가바이트, 슈퍼마이크로 등의 파트너들을 통해 만나볼 수 있다고 밝혔다.

소프트웨어 지원 측면에서, AMD는 데이터센터용 GPU를 위한 ‘ROCm’, 데이터센터의 CPU를 위한 ‘ZenDNN’, 클라이언트와 엣지를 위한 ‘바이티스 AI(Vitis AI)’ 등의 소프트웨어로 데이터센터에서 엔드포인트까지 넓은 시장을 지원하고 있다고 밝혔다. 최신 ‘ROCm 6’에서는 LLM 성능 최적화를 통해 더 높은 성능을 제공하며, ‘라마2(Llama 2) 70B’ 모델 추론 테스트에서는 MI300X와 ROCm 6 조합이 기존 MI250X와 ROCm 5 대비 8배 높은 성능을 보였다고 덧붙였다.

AI PC 위한 ‘스트릭스 포인트’, NPU 성능 3배 높아진다

임태빈 AMD코리아 컨슈머팀 세일즈 및 마케팅 이사는 일반 소비자용 AI PC를 위한 최신 라이젠 프로세서 제품군을 소개했다. 임태빈 이사는 “AI PC는 네트워크 연결 없이도 온디바이스 AI 기능들을 부담없이 활용할 수 있고, 성능 뿐 아니라 AI 활용에서의 프라이버시 문제 등에서도 자유롭다. NPU 탑재로 AI 활용에서의 전력 소비 부담도 줄였다”고 소개했다.

AMD의 최신 라이젠 8000 시리즈 제품은 ‘젠 4’ 아키텍처 기반의 CPU 코어, ‘RDNA 3’ 아키텍처 기반의 GPU 코어와 함께, 전력 효율적인 AI 프로세싱을 지원하는 ‘XDNA’ 아키텍처 기반의 ‘라이젠 AI’ NPU가 탑재된 것이 특징이다. 특히 이전 세대 ‘라이젠 7040 시리즈’ 대비 NPU 성능이 60%까지 높아져, ‘라마 2(Llama 2)’나 비전 모델 등에서의 AI 처리 성능도 40%까지 높아졌다고 밝혔다.

임태빈 이사는 “고성능 게이밍 PC에서의 AI 활용 뿐만 아니라, 외장 그래픽 없이도 충분한 AI 성능을 갖춘 노트북에 대한 시장의 요구가 커지고 있다”고 밝히며, 최신 라이젠 8000 시리즈 제품이 이런 수요를 충족시킬 것으로 기대했다.

이어 2024년 연내 출시 예정인 차세대 ‘스트릭스 포인트(Strix Point)’ 제품에 탑재될 새로운 ‘XDNA 2’ 아키텍처 기반의 NPU는 처리 성능이 지금보다 3배 높아질 것이라 밝혔다. 또한 현재의 ‘라이젠 AI’ NPU에 대한 소프트웨어 지원 강화에 대해서도 준비하고 있으며, 곧 선보일 수 있을 것이라 덧붙였다.

권용만 기자 yongman.kwon@chosunbiz.com