알리바바 클라우드가 오픈소스 대규모 언어 모델(LLM) 제품군의 최신 세대인 '큐원3(Qwen3)'를 7일 공개했다.

큐원3 시리즈는 6개의 밀집(dense) 모델과 2개의 전문가 혼합(Mixture-of-Experts, 이하 MoE) 모델로 구성됐다.

큐원3는 알리바바 클라우드가 선보이는 최초의 하이브리드 추론 모델로, 기존 거대언어모델(LLM) 기능과 고급형 동적 추론을 결합했다. 큐원3 모델은 수학·코딩·논리적 추론과 같은 복잡한 다단계 작업을 위한 사고 모드와 빠른 범용 응답을 위한 비사고 모드 간에 원활하게 전환할 수 있다.

API를 통해 큐원3에 접근하는 개발자는 최대 3만8000개의 토큰까지 사고 지속 시간을 세밀하게 조정할 수 있어, 지능형 성능과 컴퓨팅 효율성 간 최적화된 균형을 유지할 수 있다. 특히 큐원3-235B-A22B(Qwen3-235B-A22B) MoE 모델은 다른 최신 모델 대비 도입 비용을 크게 낮췄다는 게 회사 측 입장이다.

이전 모델인 큐원2.5의 두 배 규모인 총 36조개에 달하는 방대한 데이터 셋을 학습한 큐원3는 추론·지시 수행·도구 활용·다국어 작업 등 여러 분야에서 성능이 향상됐다. 다국어 역량 강화를 비롯해 고급 에이전트 통합, 우수한 추론 성능, 인간친화성 강화 등에 신경 썼다는 설명이다.

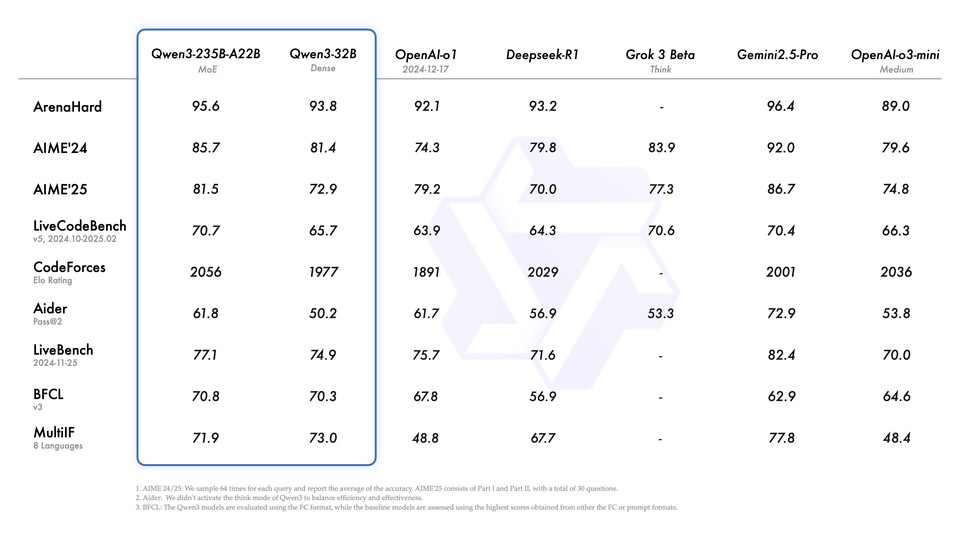

알리바바 클라우드에 따르면 큐원3는 ▲AIME25(수학적 추론) ▲LiveCodeBench(코딩 역량) ▲BFCL(도구 및 함수 호출 능력) ▲Arena-Hard(지시 최적화 LLM 평가) 등 다양한 업계 벤치마크에서 최고 수준의 결과를 달성했다. 하이브리드 추론 모델 개발을 위해 긴 CoT(long chain-of-thought, 연쇄 사고) 초기학습(cold start), 추론 기반 강화 학습(Reinforcement learning, RL), 사고 모드 융합, 일반 강화 학습을 포함하는 4단계 학습 과정도 구현했다.

큐원3 모델은 현재 허깅페이스, 깃허브, 모델스코프를 통해 무료로 다운로드할 수 있다.

김경아 기자

kimka@chosunbiz.com