엔비디아의 ‘블랙웰(Blackwell)’ 아키텍처 기반 차세대 그래픽처리장치(GPU) 'B200'이 기존 ‘H100’대비 거대언어모델(LLM) 훈련에서 2배 높은 성능을 제공한 것으로 나타났다. B200은 내년 1분기부터 일반 판매(GA: General Avalable) 될 것으로 알려졌다.

13일(현지시각) 엔비디아는 인공지능(AI) 성능 벤치마크인 MLPerf 훈련 테스트 결과, B200의 성능은 이전 세대 A100대비 12배 높은 것으로 나타났다고 밝혔다. 기존 ‘호퍼(Hopper)’ 아키텍처 기반 H100 GPU도 이전보다 30% 더 높은 새로운 결과가 나왔다.

엔비디아는 이번 결과를 지속적인 최적화를 통한 성능 극대화에 따른 것이라며 추론에서도 시스템 레벨의 최적화로 기존보다 상당한 성능 향상을 거뒀다고 밝혔다.

‘호퍼’ 기반 GPU 성능, 이전보다도 더 높아져

AI 워크로드를 위한 컴퓨트 수요는 지속적으로 늘어나는 모습이다. 특히 추론에서도 오픈AI의 o1 등 ‘긴 생각 시간’을 가지는 사용 사례가 새롭게 등장하면서 훈련 뿐만 아니라 추론에서도 컴퓨트 역량에 대한 수요가 크게 늘어날 것으로 전망되고 있다.

MLPerf는 현재 머신러닝과 AI 성능을 측정하는 데 있어 기준점으로 다뤄지고 있다. 최신 버전인 ‘4.1’에서는 이미지 생성, 거대언어모델(LLM)의 프리 트레이닝과 파인 튜닝, 추천 시스템, 이미지 인식과 자연어 처리, 그래프 등 7개 사용 사례에 대한 테스트가 포함됐다.

엔비디아는 이번 최신 MLPerf 결과 제출에서 기존 ‘H100’ GPU 기반 시스템이 다양한 최적화를 통해 동일 규모의 시스템에서 지난 2023년 6월 제출한 결과보다 30% 향상된 성능을 달성했다고 소개했다. 2023년 결과에서 GPT-3 175B(1750억 매개변수) 기준 H100과 이전 세대 A100간의 성능 차는 4.5배였다. 새로운 결과에서는 6배로 성능 격차가 더 벌어졌다.

엔비디아는 ‘호퍼’ 기반 GPU와 NV스위치(NVSwitch) 연결을 사용하는 최적화된 플랫폼이 추론 성능에서도 이전 대비 큰 폭의 성능 향상을 제공한다고 제시했다. 엔비디아가 제시한 결과에서는 GH200 NVL32 기반 시스템은 이전보다 3배 빠르게 첫 토큰을 생성했다. ‘라마 3.1 405B’ 모델에서는 네트워크와 병렬화 최적화로 처리량을 50% 높일 수 있었다. ‘확장성’ 측면에서도 엔비디아는 ‘1만1616개’ GPU 탑재 시스템의 결과를 제출하면서 데이터센터 스케일에서의 확장에서 효율성 측면을 검증했다고 제시했다.

차세대 ‘블랙웰’, 기존보다 훈련에서 2배, 추론에서는 4배 높아

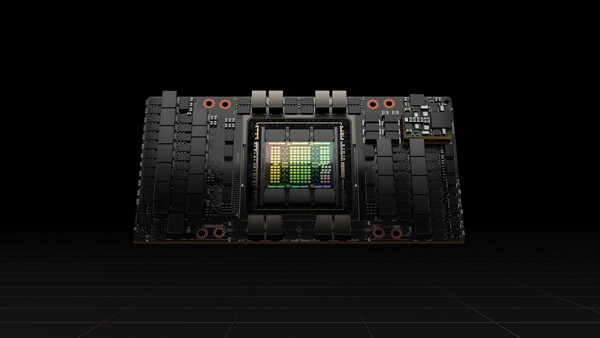

엔비디아는 차세대 GPU ‘블랙웰(Blackwell)’에 대해 GPU뿐만 아니라 다양한 구성요소들이 긴밀하게 결합된 ‘플랫폼’으로 접근하는 전략을 보이고 있다. 엔비디아는 지난 8월 블랙웰 기반 시스템의 MLPerf 추론 성능 테스트 결과를 공개했는데 당시 테스트 결과에서는 FP4 기준 H100 대비 최대 4배 뛰어난 성능을 선보인 바 있다.

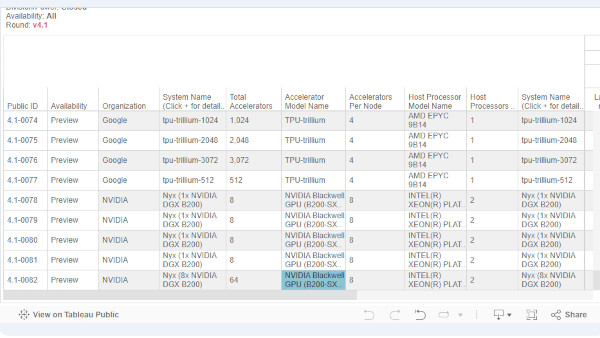

이번에 발표된 MLPerf 훈련 테스트 결과에 사용된 시스템은 블랙웰 기반의 AI 슈퍼컴퓨터 ‘Nyx’로, 블랙웰 B200이 탑재된 것으로 언급됐다. 엔비디아는 이 시스템에 대해 실제 시스템 구축과 확장에 대한 경험을 확보하고 고객에 제시하는 레퍼런스 시스템으로 소개했다. MLPerf 데이터베이스에서 테스트 시스템은 노드당 인텔 제온 플래티넘 8570 프로세서 2개와 엔비디아 블랙웰 B200 SXM 180GB GPU 8개를 탑재한 엔비디아 DGX B200 시스템 기반으로 기재됐다.

이 시스템을 기반으로 한 ‘B200’은 기존의 ‘H100’ 대비 GPT-3 175B 프리트레이닝서 가속기당 두 배 성능을 제공했다. 이는 이전의 A100 대비 12배에 이른다. 가속기당 성능은 기준 주요 항목에서 모두 최고 기록을 달성했다. ‘라마 2 70B’의 파인튜닝 성능에서는 H100 대비 2.2배 성능을 기록한 것으로 나타났다.

한편, 엔비디아는 ‘블랙웰’ 기반 시스템의 ‘풀스택 혁신’ 측면을 강조했다. 이는 AI 워크로드를 처리하는 GPU 뿐만 아니라 GPU와 GPU, CPU를 연결하는 5세대 NV링크(NVLink), 시스템간 고속 연결을 구현하는 네트워킹 기술, GPU 기반 시스템에 최적화된 소프트웨어 지원 등을 모두 포함한다. 엔비디아는 이러한 ‘최적화 구성’을 규격화해 고객에 빠르게 슈퍼컴퓨터급 시스템을 전달할 수 있는 ‘슈퍼클러스터 스케일’ 기술도 제시했다.

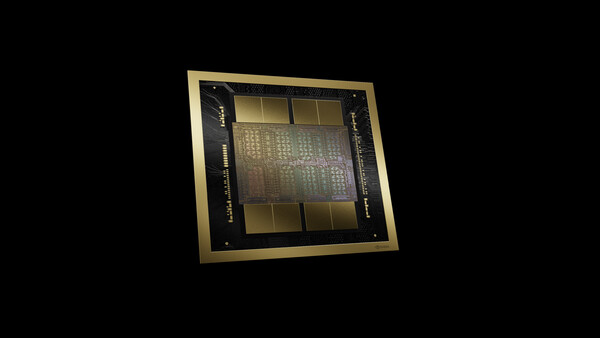

엔비디아는 블랙웰 아키텍처 기반 GPU와 시스템에 대해 “이미 대량 생산 단계”로 언급했다. 2025년에는 ‘블랙웰 울트라’를, 2026년에는 차세대 ‘루빈(Rubin)’ 아키텍처로 이어지는 계획을 제시했다.

‘블랙웰 울트라’의 경우 지금의 ‘블랙웰’보다 더 큰 용량인 288기가바이트(GB)의 HBM3e 메모리와 더 높은 처리량을 제공할 계획이다. 네트워크에서는 커넥트X-8(ConnectX-8) 슈퍼NIC(Network interface card), 스펙트럼 울트라 X800 이더넷 플랫폼과의 조합을 소개했다.

‘루빈’에서는 8스택 구성의 HBM4 메모리가 탑재될 것으로 알려졌다. 플랫폼 차원에서는 차세대 아키텍처의 중앙처리장치(CPU), 6세대 NV링크, 커넥트X-9 슈퍼NIC, 스펙트럼 X1600 이더넷 플랫폼을 조합할 계획이다. 이후 ‘루빈 울트라’의 경우는 12스택 구성의 HBM4 메모리가 탑재될 것으로 알려졌다.

권용만 기자 yongman.kwon@chosunbiz.com

- 젠슨 황 엔비디아 CEO “국가 기본 인프라와 같이 소버린 AI 갖춰야”

- AMD, 차세대 AI 가속기 ‘MI325X’… “엔비디아 H200 능가” [AMD AI 2024]

- 폭스콘 “엔비디아 ‘GB200’ 위한 세계 최대 생산시설 멕시코에 건설 중”

- 엔비디아, 미국 정부 추진 ‘글로벌 AI 포용성 이니셔티브’ 동참

- 엔비디아, 라마 3.1 활용한 ‘AI 파운드리’ 서비스 발표…맞춤형 슈퍼모델 구축 지원

- GPU서버 ‘델 파워엣지 XE9680’ ②성능편 “AI 위한 최고 수준 성능·생산성” [리뷰]

- GPU서버 ‘델 파워엣지 XE9680’ ①기능편 “AI 시대 혁신 엔진” [리뷰]

- 차차세대 GPU ‘루빈’에서 AI로보틱스까지…대만에서 꺼낸 젠슨 황 로드맵 [컴퓨텍스 2024]

- 엔비디아, 소프트뱅크와 일본 최대 AI 슈퍼컴 구축… “세계 최초 블랙웰 기반”

- 손정의 소프트뱅크 회장 “PC와 모바일 다음은 ‘퍼스널 AI 에이전트’ 시대 될 것”

- 레노버·에이수스 ‘지스타 2024’ 이벤트 진행 외 [PC마켓]

- 엔비디아 “3분기 매출 전년비 94% 성장, 데이터센터는 전년비 112% 늘어”

- 전 세계 슈퍼컴, 블랙웰·인스팅트 등장에 ‘지각 변동’ 기대감 [권용만의 긱랩]

- “국내 확보한 H100 GPU 2000개” 사실일까?① [AI GPU 기근설]

- H100 GPU 공급난, 통계 인용 ‘무리수’ 가능성도② [AI GPU 기근설]

- H100 GPU, 구하기도 어렵지만 쓰기는 더 어려워③ [AI GPU 기근설]