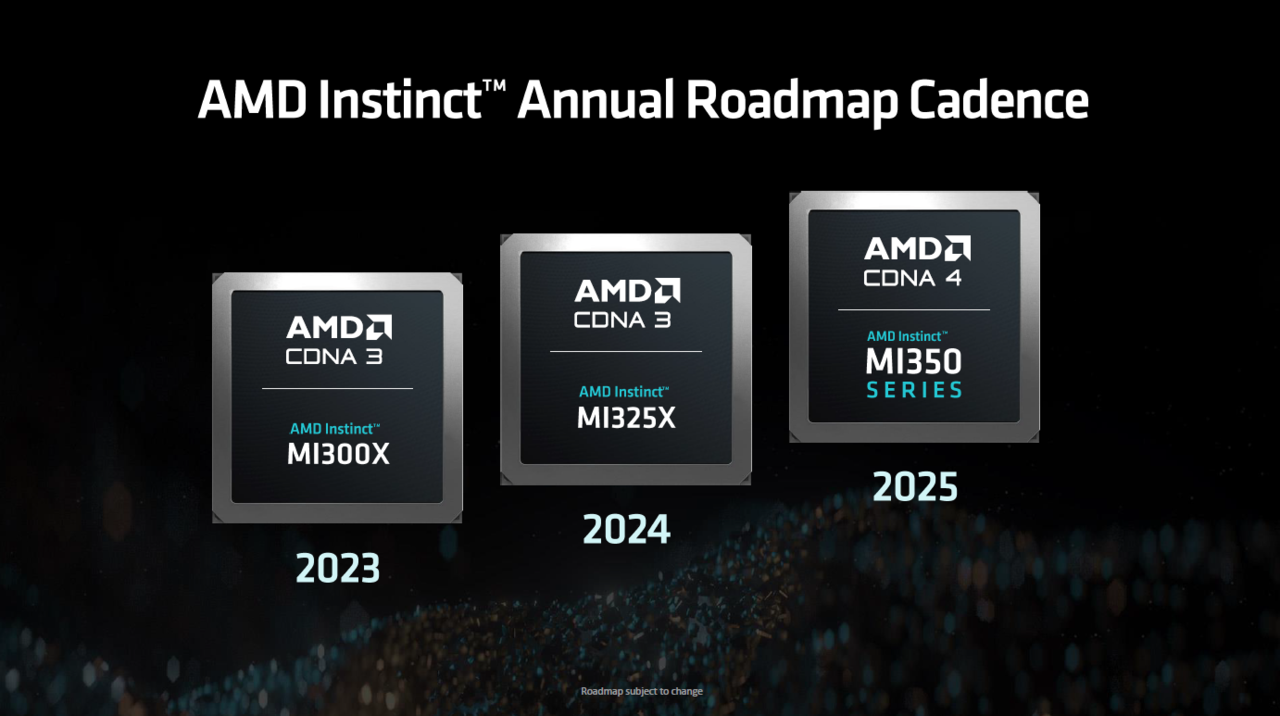

인공지능(AI) 모델의 성능이 빠른 연산에 좌우되는 만큼 이를 돕는 'AI 가속기'의 존재감이 더욱 커지고 있다. 현재까지 이 분야 선두주자는 엔비디아로 꼽힌다. AMD는 이를 겨냥해 AMD 인스팅트(Instinct™) 가속기 'MI325X'를 출시했다. 2025년과 2026년에는 각각 MI350, MI400 시리즈를 선보일 예정이다.

AMD는 11일(현지시각) 미국 캘리포니아주 샌프란시스코에서 열린 ‘AMD 어드밴싱 AI’ 행사에서 새로운 인스팅트 AI 가속기 제품군을 선보였다.

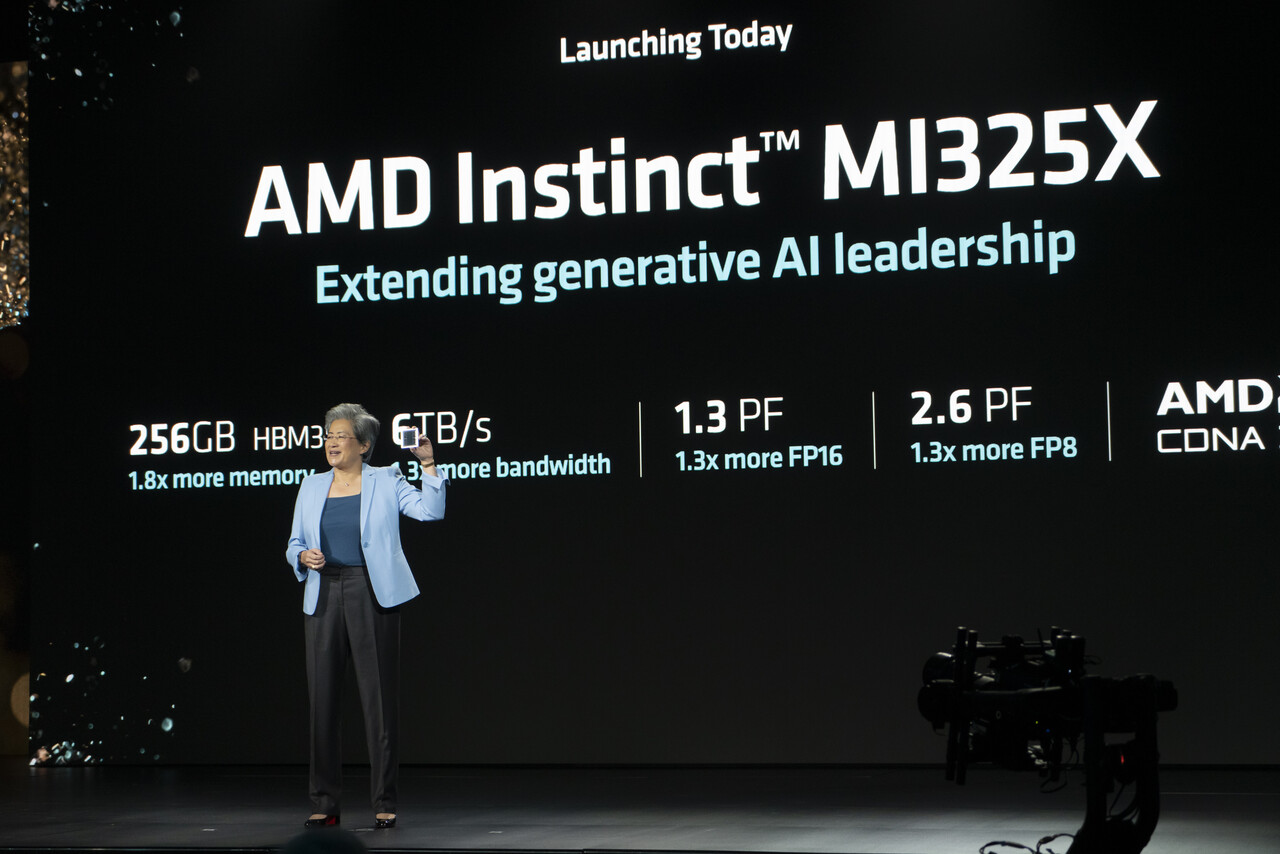

MI325X는 지난해 6월 공개된 AMD의 고성능 AI 가속기 라인업인 인스팅트 MI300X의 후속 제품이다. 256기가바이트(GB) HBM3E 메모리와 초당 6테라바이트(TB)의 메모리 대역폭을 제공한다. 이는 전작인 MI300X 대비 각각 33%, 13% 향상된 수치다. 8개를 연결한 플랫폼 모듈 구성으로 활용할 경우 초당 896GB의 인피니티 패브릭 대역폭, 총 2TB의 HBM3E 메모리, 48TB의 메모리 대역폭을 자랑한다.

AMD에 따르면 MI325X의 연산성능은 FP8(8비트 부동소수점) 기준 20.8PF, FP16(16비트 부동소수점) 기준 10.4PF를 기록하며 경쟁 제품인 엔비디아의 H200와 비교했을 때 각각 1.3배 우수한 것으로 나타났다. 추론 성능 역시 엔비디아 H200 HGX 시스템 대비 라마 3.1 405B 모델은 1.4배, 라마3.1 70B 모델은 1.2배 더 빠른 처리 속도를 자랑한다. 훈련 기능도 강화돼 단일 제품으로 비교 시 H200 대비 라마2 7B 모델을 1.1배 빠르게 학습한다. 플랫폼 구성에서는 라마 2 70B 모델과 동등한 성능을 자랑한다.

AMD 측은 4분기 중 MI325X 생산을 시작하고 내년 1분기부터 주요 파트너사를 통해 판매에 돌입한다는 계획이다.

이날 AMD는 2025년 출시 예정인 차세대 인스팅트 MI350 시리즈의 주요 스펙도 공개했다. MI350 시리즈는 3나노미터(nm) 공정과 CDNA4 아키텍처를 기반으로 제작될 예정이다. 최대 288GB HBM3E 메모리와 FP4, FP6 처리를 지원한다. 플랫폼 모듈 구성 시 최대 2.3TB 메모리와 64TB 메모리 대역폭을 갖추고 최대 74PF의 FP4, FP6 연산 성능을 제공할 전망이다.

세부 모델인 MI 355X는 MI 325X와 비교해 1.8배 빠른 FP16, FP8 처리 성능이 예상된다. 3세대 이전 제품인 MI300과 비교하면 7.4배 향상된 AI 플롭스 처리 성능으로 처리 가능한 모델 크기는 6배 커졌다. AMD는 올해 4분기 중 인스팅트 MI325X 생산을 시작해 내년 1분기부터 주요 파트너사에서 판매를 시작한다. 차기 모델인 MI400 시리즈는 2026년 출시가 예상된다.

아울러 AMD는 AI 개발 생태계 강화를 위해 GPU 프로그래밍을 위한 소프트웨어 스택인 ROCm 플랫폼 고도화 작업을 진행하고 있음을 알렸다. 하드웨어를 효과적으로 활용하기 위해서는 하드웨어의 연산 유닛을 직접 활용할 수 있는 프로그래밍 모델, 하드웨어와 주요 소프트웨어 개발 프레임워크를 연결하는 소프트웨어 스택까지 모두 충실히 갖춰야하기 때문이다.

이에 AMD는 개방형 소프트웨어 생태계에 적극적으로 투자하기 위해 ROCm 플랫폼에 공을 들이고 있다. AMD ROCm 6.2 버전은 이전 버전인 6.0과 대비 거대언어모델(LLM) 처리 성능을 최소 1.9배에서 2.8배까지 끌어올렸다. 훈련 성능 또한 평균 1.8배 향상됐다. 최근 인수한 AI 스타트업 사일로AI를 통해 유럽 언어 기반의 대언어모델(LLM) 지원과 ROCm 호환성 향상에도 박차를 가하고 있다.

샌프란시스코=홍주연 기자 jyhong@chosunbiz.com

- 리사 수 CEO “AMD 목표는 AI 생태계 리더” [AMD AI 2024]

- “성능 자신있다” AMD 에픽으로 시장 점유율 30% 도전 [AMD AI 2024]

- “비즈니스 노트북도 이제 AI·코파일럿+ PC” [AMD AI 2024]

- 포레스트 노로드 AMD 수석부사장 “CPU·GPU·네트워킹 3박자 갖춰 AI 시장 선도” [AMD AI 2024]

- 노벨상이 주는 AI에 대한 경고 [인공지능 365]

- 인텔·AMD 뭉쳤다… “x86 생태계 미래 조성 자문 그룹 설립”

- AMD ‘2세대 버설 프리미엄’ 공개… “차세대 가속기 위한 CXL 3.1지원”

- 엔비디아 “차세대 블랙웰, LLM 훈련에서 H100 두 배 성능”

- 엔비디아, 소프트뱅크와 일본 최대 AI 슈퍼컴 구축… “세계 최초 블랙웰 기반”

- 손정의 소프트뱅크 회장 “PC와 모바일 다음은 ‘퍼스널 AI 에이전트’ 시대 될 것”

- AMD, 글로벌 인력 4% 감원 계획… “AI 칩 집중 전략”

- 전 세계 슈퍼컴, 블랙웰·인스팅트 등장에 ‘지각 변동’ 기대감 [권용만의 긱랩]